Savaş alanında hangi hedefin vurulacağına, kimin yaşaması kimin ölmesi gerektiğine algoritmalar mı karar verecek? Küresel bir “Yapay Zekaya” dayalı “otonom silah yarışının” eşiğinde miyiz?

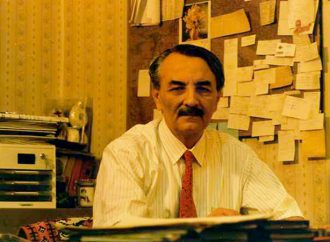

Otonom silah sistemleri konusunda gelecekte bizin neler beklediği konusunda Stockholm merkezli Uluslararası Barış Araştırmaları Enstitüsü’nün (SIPRI) Yapay Zekâ Programları Direktörü Dr. Vincent Boulanin, bir otonom silah sistemleri yarışı değil belki ama yapay zekanın yeteneklerini silah sistemlerini de kapsayacak şekilde geliştirme konusunda bir yarış olduğunu belirtiyor.

Cumhuriyet’ten Özgür Ulusoy’un sorlarını yanıtlayan Boulanin’e göre, otonom silah sistemleri insan müdahalesi olmaksızın bir “hedef profilini” seçip saldırı gerçekleştirebilen silahlar olarak tanımlanıyor genel olarak. Sisteme “belirli bir bölgedeki belirli özelliklere sahip tankları hedef al” talimatı veriliyor. Hangi lokasyonların ve hangi hedef tiplerinin seçileceğine öncesinde insanlar karar veriyor; ancak saldırının kendisi otonom olarak gerçekleşiyor.

Otonom silahların uzun süredir tank, gemi gibi net biçimde tanımlanabilen askeri hedeflere karşı kullanıldığını kaydeden Boulanin’e göre asıl kritik mesele hedefin insan olması durumunda başlıyor:

“Bir insanın meşru askeri hedef mi yoksa sivil mi olduğunun ayırt edilmesi son derece karmaşık. Bu, çok daha gelişmiş ve hataya yer bırakmayan bir teknoloji gerektiriyor.”

“Kimin yaşayacağına algoritmalar mı karar verecek?” sorusuna Boulanin şöyle cevap veriyor:

“Algoritmalar karar vermez; belirlenen parametrelere göre hareket eder. Otonom silahlar, hedef kütüphanesinden seçim yapar” yanıtını veriyor. Ancak bu ayrım, etik kaygıları ortadan kaldırmıyor. Otonom silahlar konusundaki uluslararası tartışmalar BM Cenevre platformunda devam ediyor. Ancak Ukrayna ve Gazze’de drone’lar gibi yapay zekaya dayalı sistemlerin kullanıldığı savaşlar, bu tartışmaları daha da acil hale getirmiş durumda.”

Boulanin’e göre sorun şu:

“Devletler savaş halindeyken, bu teknolojilerin kullanımına dair etik ve hukuki normlar üzerinde uzlaşmak çok daha zor. Barış dönemlerinde düzenleme yapılması bu yüzden hayati.”

Boulanin, hukuki anlamda tamamen bir “Vahşi Batı” durumundan söz edilemeyeceğini söylüyor. Uluslararası hukuk, otonom silahların kullanımına zaten bazı kısıtlamalar getiriyor. Ancak çatışmalara taraf devletlerin bu konudaki tartışmaları yapıcı bir şekilde sürdürmeyi isteyip istemedikleri bir soru işareti. Büyük güçler bağlayıcı düzenlemelere karşı temkinli.

BM Genel Sekreteri Antonio Guterres’in çağrısıyla, otonom silahlar konusunda yıl sonuna kadar bir hukuki çerçeve oluşturulması hedefleniyor. Boulanin, asıl sorunun “düzenleme olacak mı?” değil, “nasıl bir düzenleme olacak?” olduğunu söylüyor.

Bağlayıcı mı olacak? Yaptırım içerecek mi? Hangi teknolojileri sınırlayacak? Yanıtlar büyük ölçüde jeopolitik iklime bağlı.

Boulanin, geleceğin savaşlarına dair iki net eğilime işaret ediyor: Birincisi, Ukrayna savaşının da gösterdiği gibi düşük maliyetli ve kaybedilmesi göze alınabilen drone’ların, yüksek maliyetli savaş uçaklarının yerini alması beklenebilir. İkincisi ise, yapay zekâdaki hızlı ilerleme, özellikle de büyük dil modellerinin askeri alanda veri işleme ve sistem tasarımı açısından sunduğu yeni imkânlar.

Boulanin’e göre nükleer silahların kullanımı söz konusu olduğunda uluslararası alanda nadir görülen bir uzlaşı mevcut: Nükleer silahların kullanım kararının otonom sistemlere bırakılmaması. “ABD ve Çin bile, nükleer silahların fırlatılması kararının insanlarda kalması gerektiği konusunda mutabakata varmıştı” diyen Boulanin makine öğrenmesine dayalı sistemlerin nükleer mimariye entegrasyonunun son derece riskli olduğunu söylüyor. Çünkü bu sistemlerin nasıl başarısız olabileceğini öngörmek çok zor. Bu sistemlerin üretiminin ve edinilmesinin görece kolay olması ise bir başka sorun. Devletlerin yanı sıra devlet dışı aktörler de bu silahlara erişebilir çünkü.

Leave a Comment

Your email address will not be published. Required fields are marked with *